İlahi Yetki: Ya da, Yapay Zeka Silahlanma Yarışından Korkmayı Nasıl Bıraktım ve Onu Sevmeyi Öğrendim

Yayınlanma tarihi 2024-12-23365 günden uzun süre önce güncellendi Lisans CC BY-NC-SA 4.0 artificial intelligencecomputer sciencewritingpersonal İçindekiler

İlahi Yetki

X'te anonim olarak birçok yapay zeka araştırmacısını, jailbreak uzmanlarını, akademisyenleri ve hem açık hem de kapalı kaynaklı araştırma laboratuvarlarından önde gelen isimleri takip ediyorum. Bu takip, Yapay Zekanın Evrimi ve İlerleyişi hakkındaki daha geniş tartışmalara katılmak ve bu etkili kişilerle aynı odada bulunuyormuş hissine oldukça yakın duygu veren bir deneyim. Bizden üstün/ötede bir şey yaratma görevini düşünürken, hem kendi insanlığımızı, hem de yarattıklarımızın özerkliğini korumaya çalıştığımız çok çarpıcı ve yoğun tarihi bir dönemden geçiyoruz. Bu, çok hassas bir denge gerektiriyor ve bu kritik zamanda, paradigma değişimi gerçekleştikten sonra değil de tam gerçekleşirken bu bilgiyi özümsemek benim için büyüleyici. Büyük laboratuvarlardaki araştırmacıların, bulundukları öncü konumda neler olup bittiği hakkında sessiz kalmasının zor olduğunu düşünmek imkansız değil. Bu da, bize daha önceki teknolojik devrimlerde neredeyse imkansız olacak şekilde, önde gelen araştırmacıları ve düşünce liderlerini takip ederek, perde arkasına bir göz atma fırsatı sunuyor.

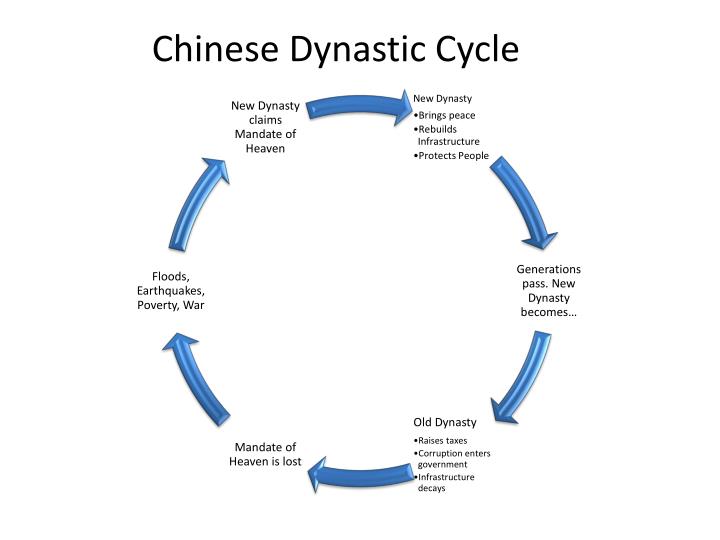

Size sıkça bahsedilen “İlahi Yetki” kavramını tanıtmak istiyorum. Bu, Çin hanedanları arasındaki güç transferini ve siyasi yönetimi meşrulaştırmak için geliştirilen bir Çin felsefesi kavramıdır.

İlahi Yetki, M.S. 1912’deki imparatorluğun sonlamasına kadar, hükümdarların ve devletlerin başarısını ve başarısızlığını açıklayan temel sosyo politik bir Çin felsefesiydi. Bir hanedan devrildiğinde Çin bilgelerinin değişmez şekilde sunduğu açıklama, hanedanın yalnızca ilahi güç tarafından verilen yönetme hakkını kaybetmiş olmasıydı. Bu bağlamda, ilahi güç, kişi olarak bir tanrıyı değil, kozmik ve her şeyi kapsayan bir gücü ifade ediyordu. Günümüz tarihçilerinin çoğu, İlahi Yetki teorisinin Zhou hanedanının Shang’ı devirmesini meşrulaştırmak için bir icat olduğu konusunda hemfikirdir. Sonuçta, kral, halkının babasıydı ve babalık otoritesi en eski zamanlardan beri Çin toplumunun temel çimentosuydu. Bu nedenle, bir babaya karşı isyan olağanüstü bir gerekçe gerektiriyordu.

Bu kavram temel olarak şunları öne içerir:

- Yöneticiliğin İlahi Onayı: İlahi güç, hükümdara adil ve erdemli bir yönetme hakkı verir

- Yetki Üzerinden İlahi Yönetim: Eğer bir hükümdar yozlaşır veya iyi yönetemezse, İlahi güç yetkisini geri çeker

- Kozmik İşaretler ve İsyan Yoluyla Siyasi Meşruiyet: Doğal afetler, sosyal huzursuzluk ve siyasi çalkantılar bir hükümdarın yetkiyi kaybettiğinin işaretleri olarak görülür

- Yöneticiliğin Döngüsel Doğası: Yozlaşmış bir hükümdara karşı başarılı bir isyan, İlahi Gücün Yetkisini geri çekip daha layık, yeni bir hükümdara verdiğinin kanıtı olarak görülür

Yapay Zeka Silahlanma Yarışı

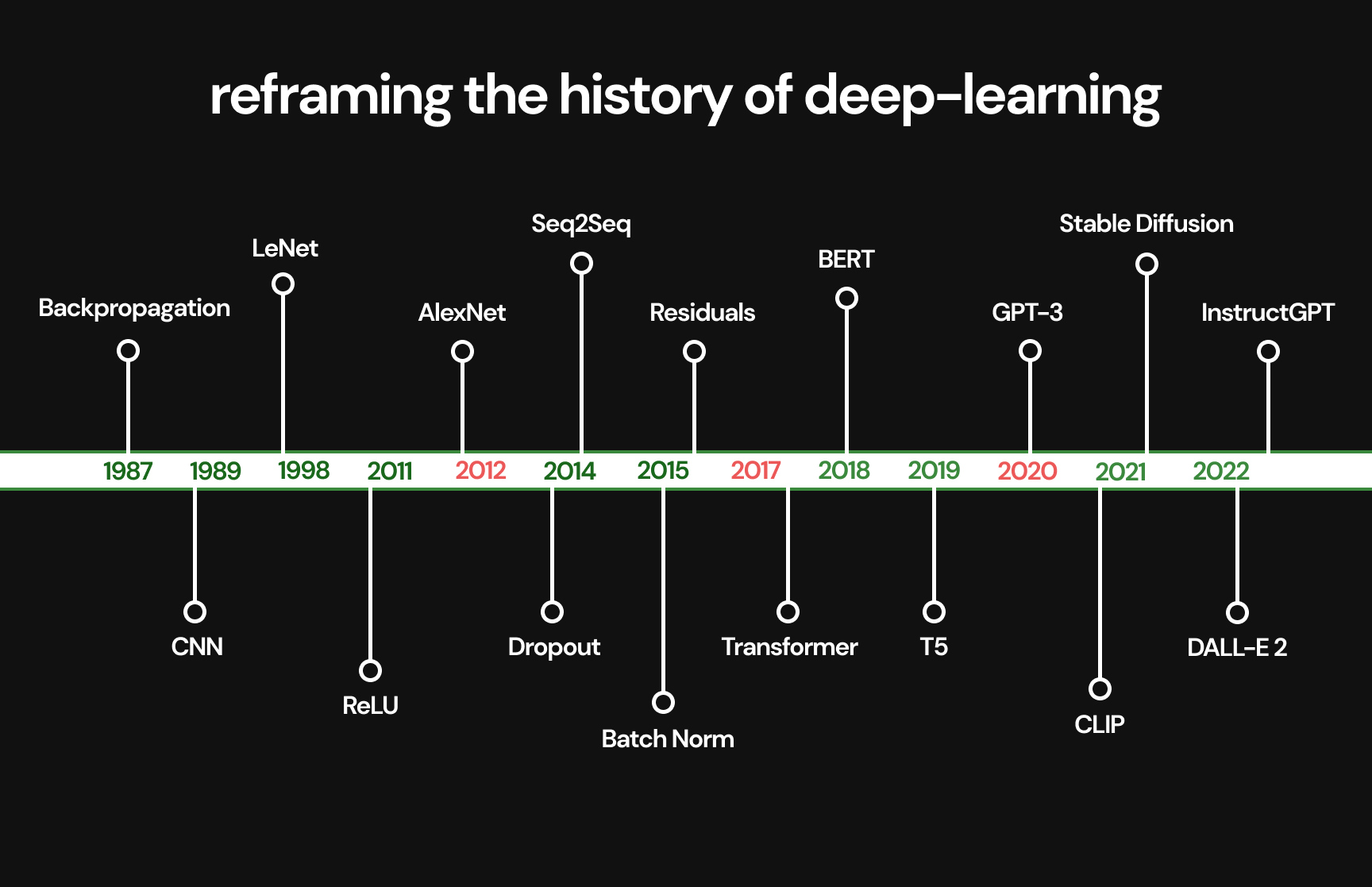

Demiryolları, buharlı motorlar, elektrik, telefon, otomobiller, kişisel bilgisayarlar, internet, web tarayıcıları gibi üretkenliği artıran üstel teknolojik gelişmelerde, büyük oyuncuların sürekli bir hakimiyet mücadelesi içinde endüstri liderliği el değiştirir. Bu mücadele, herhangi bir zamanda kimin “İlahi Yetki”yi elinde tuttuğunun bir yansımasıdır. Şu anda, daha önceki dönüştürücü inovasyon çağlarını andıran tarihi bir teknolojik savaş tanık oluyoruz.

Web Tarayıcı Savaşları'ndan bir örnek: Google Chrome'un tarayıcı üstünlüğüne yükselişi pazarın ani bir şekilde ele geçirilmesi değil, stratejik bir evrimdi ve Google burada birkaç kilit avantajı kullandı. Chrome 2008'de piyasaya sürüldüğünde, tarayıcı pazarı ağırlıklı olarak Microsoft'un Internet Explorer'ı ve Mozilla Firefox'u tarafından domine ediliyordu. Google, tarayıcı pazarına, radikal performans, minimalist tasarım ve yüksek eklenti desteği, hızlı sürüm döngüleri, ekosistemlerinin tamamıyla entegrasyonlar ve Chromium projesinin açık kaynak temeli üzerine odaklanan devrimci bir stratejiyle girdi. 2012'ye gelindiğinde Chrome, dünyada en çok kullanılan tarayıcı olarak Internet Explorer'ı geçmişti ve 2020'de küresel tarayıcı pazar payının %65'inden fazlasını kontrol ediyordu. Web tarayıcı pazarında "İlahi Yetki" şu şekilde evrildi: Netscape (1994 - 1998), Internet Explorer (1998 - 2004), Firefox (2004 - 2008), Chrome (2008 - günümüz)

Yapay zeka söz konusu olduğunda, önce alandaki tüm önemli rakipleri incelemeli, sonra mevcut durumlarını tartışmalıyız.

Batı:

- OpenAI (GPT) - Microsoft

- Google Deepmind (Gemini) - Alphabet

- Anthropic (Claude) - Amazon

- Meta (Llama) - Açık Kaynak Pazar Lideri

- xAI (Grok) - Elon Bucks (Tesla)

- Mistral (Mistral Large)

- SSI (henüz yayın yok) - Ilya Sutskever ve Daniel Gross’u hafife almayın

- Cohere (Rerank 3.5)

- Amazon - Amazon (3 Aralık 2024 itibariyle yeni model serisini yayınladı)

- AI21 Labs

- Nous DisTrO - Nous Research

Doğu / Çin:

Eski Dört Yapay Zeka Ejderhası (Odak LLM’lerden çok Görsel Tanıma üzerine)

- Yitu Technology

- SenseNova - SenseTime (LLM’i olan tek Eski Ejderha)

- Megvii

- CloudWalk Technology

Orta Yaşlı Dört Panda

- Qwen 72B - QwQ (Şu anki Açık Kaynak lideri) - Alibaba

- Ernie Bot - Baidu

- Hunyuan (Yeni video versiyonu yayınlandı) - Tencent

- ByteGPT - ByteDance

Yeni (Güncellenmiş) Yapay Zeka Kaplanları

- Yi - Lightning - 01.ai

- DeepSeek - DeepSeek

- Baichuan - Baichuan AI

- GLM-4-Plus - Zhipu AI

- Kimi - Moonshot AI

- Hailuo AI - Minimax

Kıyaslama Testleri (Benchmark)

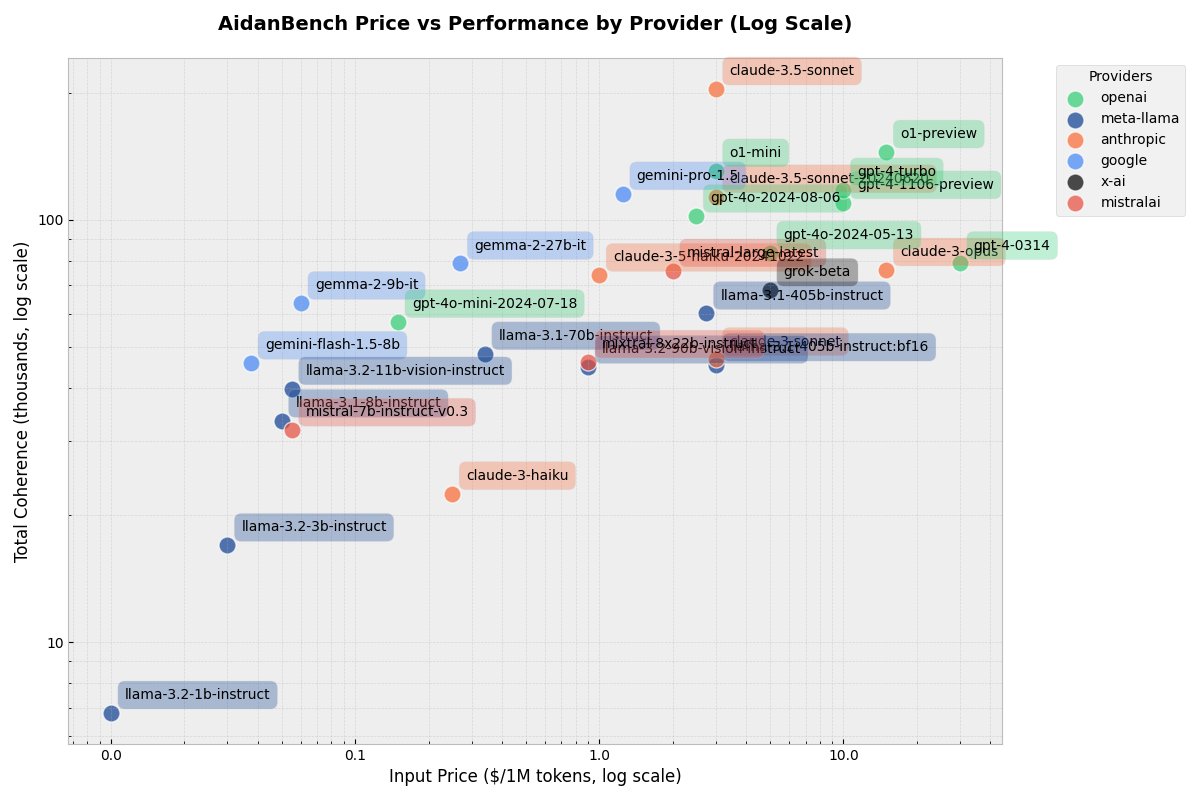

Kıyaslama testleri, yapay zeka dünyasında kritik bir rol oynar. Kıyaslama testleri, farklı modellerin çeşitli görevlerdeki yeteneklerini ölçmek ve karşılaştırmak için standart araçlar olarak kullanılır ve iyi performans'ın nasıl tanımlanacağını belirlemeye yardımcı olurlar. Ancak, şunu belirtmek önemlidir. Kıyaslama testlerindeki iyi performans'ın tanımlanması bazen yanıltıcı olabilir. Belirli metrikler veya görevlerde üstün performans gösteren modeller, adaptasyon ve daha geniş yeteneklerin önem kazandığı gerçek dünya senaryolarında yetersiz kalabilir.

OpenAI, lmsys liderlik tablosunda kuruluşundan bu yana baskın konumunu sürekli korudu ve liderliği her kaybedişinde 1. sıradaki konumunu geri almayı başardı. “Lmsys, belirli modellerin gerçek performansını doğru bir şekilde yansıtan mükemmel bir kıyaslama mıdır?" sorusunun kesin cevabı hayırdır. Yine de, en bilinen kıyaslama olarak kalıyor ve beğenseniz de beğenmeseniz de bir statü sembolü görevini görüyor. Şu anda, LLM teknoloji dünyasında bu kıyaslama sonuçları konusunda, afedersiniz ama, sidik yarışı gibi bir durum var.

François Chollet’nin Arc Challenge’ı, Scale AI, Epoch AI, Artificial Analysis, AidanBench, SimpleBench, Open LLM Leaderboard, LiveBench ve çeşitli kodlama kıyaslamaları gibi diğer kıyaslama platformları, hangi modelin belirli alanlarda üstün olduğuna dair daha geniş bir resim sunuyor.

Her model kendine özgü, farklı alanlarda değerli ve yetenekli. Bunları keşfetmek LLM'lerin gerçek gücünü ortaya çıkarıyor. Yaygın olarak kabul gören bazı veri setleri ve kıyaslama testleri şunlar:

- TruthfulQA - Doğruluk değerlendirmesi

- MMLU — Çoklu görev dil anlama

- HellaSwag — Sağduyu muhakemesi

- BIG-Bench Hard — Zorlayıcı muhakeme görevleri

- HumanEval — Kodlama zorlukları

- GSM8K - İlkokul seviyesi matematiksel muhakeme zorlukları

- CodeXGLUE — Programlama görevleri

- MT Bench — Karmaşık konuşma yeteneği

Sonuç olarak, kullanıcılar hangi modelin kendi özel kullanım durumlarına en uygun olduğunu belirlemek için bu LLM'leri bizzat deneyimlemeli. Çünkü hiçbir kıyaslama testi her uygulamanın karmaşıklığını tam olarak yakalayamaz.

Jailbreaking

Jailbreaking, bir yapay zeka modelinin güvenlik önlemlerini aşma uygulamasıdır. Basit komut enjeksiyonuyla başlayan bu uygulama, günümüzde model bağlam karışıklığını kullanan daha karmaşık tekniklere evrildi. Saldırganlar, güvenlik kısıtlamalarını aşmak için sürekli olarak yeni yöntemler geliştiriyor (kırmızı takım çalışması).

Bu alanda en öne çıkan figür, X'te Pliny; jailbreaking'in tartışmasız lideri olarak kabul ediliyor. Yeni bir model yayınlandığında, Pliny’nin genellikle dakikalar (nadiren saatler) içinde modelin jailbreak versiyonunu sunması, "kırılmamış" LLM'lerin normalde reddettiği sorulara yanıt verebilir hale getirmesi dikkat çekicidir; "metamfetamin nasıl sentezlenir?", "insan ırkını en etkili şekilde nasıl yok edebilirim?" ve "evimde biyolojik silah nasıl üretebilirim?" gibi sorular, LLM’lerin kesinlikle reddettiği ama jailbreak ile yanıtlanabilen sorulardı.

Pliny ayrıca godmod3 adında, her açık veya kapalı modelin hazır jailbreak versiyonunu sunan erişilebilir bir LLM platformu sağlıyor. Bu konuyu Pliny’nin websitesini tanıtmak için değil, günümüz modellerinin jailbreak’inin ne kadar basit ve kolay hale geldiğini göstermek için yazıyorum. Girişimcilerle yaptığımız toplantılarda, kurucuların “Evet, bizim modelimiz kırılamaz.” iddialarını duyduğumda, Pliny’nin saniyeler içinde güvenlik önlemlerini aşıp modelin iç sırlarını ortaya çıkarabileceğini bilerek gözlerimi devirmekten kendimi alamıyorum.

Jailbreaking’in kötü amaçlı yazılım veya kötüye kullanımla ilgili olmadığını anlamak önemli. Destekçiler bunu, LLM’lerin eğitim sonrası sansürden ve zararlı düzenlemelerden uzaklaşarak tam kapasitelerini ortaya çıkarmasını sağlayan, yapay kısıtlamaların kaldırılması olarak görüyor.

Tahtın Adayları

OpenAI (CPO)

GPT serisi modelleri bize getiren ve dünyaya LLM’lerin gücünü öğreten özgün ve öncü konumdaki OpenAI, ölçeklendirme ve dönüşümcü mimarilerine erken girmeleri ve iddialı olmaları sayesinde yapay zeka yarışında uzun süredir lider konumundadır. Alec Radford’ın GPT-1 üzerindeki erken çalışması, günümüzün modern LLM’lerinin önünü açmıştır. Ilya Sutskever’in “Ölçek Her Şeydir” felsefesi parlak bir mühendislik ekibiyle birleşince, bugün bulunduğumuz noktaya geldik. Tüm bu çabalar, GPT-4o yanısıra paradigma değiştiren o1 ailesi gibi modellerde, modelin daha uzun düşünmesini ve daha zor görevlerde akıl yürütmesini sağlayan test-zamanı-hesaplama yetenekleriyle GPT-4o’dan ayrılarak zirveye ulaştı. .

Belirli bir süre boyunca OpenAI hiç hata yapmadı. Alandaki en iyi araştırmacılara sahip, en iyi model onlardaydı ve hiç kimse sunduklarına yaklaşamıyordu bile. “İlahi Yetki” tam güçteydi ve liderlikleri sarsılmaz görünüyordu. Sonra darbe geldi ve Sam Altman kısa süreliğine şirketten uzaklaştırıldı.

Sam Altman’ın CEO olarak “ölüşü ve dirilişi” (17-22 Kasım 2023), OpenAI üzerindeki mutlak gücünü pekiştirmesiyle sonuçlandı. O zamandan beri OpenAI, teknolojik inovasyona ve yapay zeka modellerinin ürünleştirilmesine devam etti. Ancak, bu süreç, alignment (hizalama) ekibinin kapatılması ve orijinal 8 kurucu ortaktan 3’ünün daha ayrılmasının gölgesinde gerçekleşti. En dikkat çekici ayrılıklar arasında, Ilya Sutskever’in kendi girişimi Safe Superintelligence Inc. (SSI)’yi kurmak için, Jan Leike’nin Anthropic’in alignment ekibini yönetmek için ve Mira Murati’nin kendi startup’ı Mira’yı kurmak için yakın zamanda ayrılması bulunmaktadır. Alignment ekibinin birçok üyesi ya başka bölümlere kaydırıldı ya da OpenAI’dan tamamen ayrıldı.

OpenAI, sektördeki öncülerden birçok önemli araştırmacıyı kaybetti ve bunların çoğu ana rakipleri Anthropic’e katıldı. Dario Amodei (OpenAI’ın eski Araştırma Başkan Yardımcısı ve Anthropic’in kurucusu), Chris Olah, Paul Christiano, Daniel Ziegler, Samuel R. Bowman dahil olmak üzere, hepsi yapay zeka güvenliği ve alignment araştırmalarında çok önemli isimlerdi. Bu durum şüphesiz OpenAI’ın uzun vadeli yönü, istikrarı ve Sam Altman’ın artan gücü hakkında sorular doğurdu.

2015’te Sam Altman’ın Elon Musk’a gönderdiği bir iç e-postada, en büyük rakiplerinin Google olacağını belirtiyordu:

İnsanlığın yapay zeka geliştirmesini durdurmanın mümkün olup olmadığını çok düşünüyorum. Cevabın neredeyse kesinlikle hayır olduğunu düşünüyorum. Eğer bu kaçınılmazsa, bunu Google’dan başka birinin ilk yapması iyi olur gibi görünüyor. YC’nin yapay zeka için bir Manhattan Projesi başlatmasının iyi olup olmayacağı hakkında düşüncelerin var mı?

OpenAI tüm gücüyle çalışıyor ve ChatGPT’nin ürünleştirilmesine ağırlık veriyor. Şu anda “12 Days of OpenAI” kampanyasını yürütüyorlar (hafta sonları hariç), her gün yeni özellikler duyuruyorlar. İlk gün, tüm OpenAI ürünlerinde kullanım limiti olmayan o1-pro için 200 dolar seçeneğini sundular. Yoğun kullanıcılar için bu orta seviye fiyatlandırma kritik bir boşluğu dolduruyordu. Önceki 20 dolar seviyesindeki gelişmiş modellere verilen haftada sadece 50 sorgu hakkı, sürekli yapay zeka erişimi sağlamak için yeterli değildi.

Ekonomik açıdan bakıldığında durum çarpıcı. 20 dolar seviyesindeki OpenAI, pahalı test-zamanı-hesaplama maliyetleri nedeniyle muhtemelen her sorguda zarar ediyordu. 200 dolar seviyesinde bile karlılık hala şüpheli. Anthropic de benzer zorluklarla karşı karşıya; bazen kullanıcıları Haiku modeline yönlendiriyor veya Sonnet kullanılamadığında kullanım limitleri getiriyor. Optimal fiyat noktası belirsiz kalsa da, orta seviye bir abonelik seçeneği bu şirketler için gerekli bir evrim gibi görünüyor.

o1-preview umut vaat etse de, o1-pro için ilk kıyaslama sonuçları tatmin edici değil. Tam API erişimi olmadan, o1 sisteminin tamamı hakkında kesin yargılara varmak henüz erken.

Güvenilen araştırmacıların OpenAI’dan ayrılması ve şirket içi deneyimlerini daha açık bir şekilde paylaşmaya başlamaları, yapay zeka araştırma topluluğunda artan bir yabancılaşmaya yol açıyor. Şirket, potansiyel getirisi garanti olmayan ama maliyetli araştırmalar yerine, ürün geliştirmeye öncelik vermeye ve mevcut tüketici tabanına hizmet vermeye odaklanıyor. Hâla yeniliklere ve sınırları zorlamaya devam etseler de, son gelişmeler önceliklerde bir değişime işaret ediyor. Özellikle Microsoft’un AGI’ye ulaşıldığında %49’luk hissesinden vazgeçme anlaşmasının, daha fazla finansman karşılığında kaldırılması dikkat çekici.

Temel model 4o ile ilgili önemli bir hayal kırıklığı var. Birçok yinelemeye rağmen, GPT-4’e kıyasla beklenen önemli yükseltmeyi sağlayamadı. Topluluk, yeni yeteneklerin kilidini açacak yeni, kapsamlı bir ön-eğitimli model görmeyi arzuluyor. Ancak, “12 Days of OpenAI” hala devam ediyor ve bir GPT-4.5 duyurusu ihtimali gündemde olduğundan, onları henüz gözden çıkarmamak gerekiyor. Bu analizin devamında göreceğimiz gibi, OpenAI’ın “İlahi Yetki” üzerindeki hakimiyeti hiç olmadığı kadar zorlanıyor, hem bireysel rakipler tarafından hem de yönü ve orijinal misyonuna bağlılığı hakkında temel sorularla.

Google (CEO)

Google’ın ürüne dönüştürme süreci oldukça yavaş olsa da (Logan Kirkpatrick’in liderliğinde 10 kat iyileşti), en iyi araştırmacılarını daha küçük laboratuvarlara kaybetmeleri ve sınırları zorlayamamaları onları yarışta her zaman iki adım geride bıraktı. Ancak hiçbir zaman yarıştan çıkmadılar, çünkü en büyük avantajları TPU’lar. TPU’larını kendileri tasarlayıp ürettikleri için, NVIDIA donanımına bağımlı rakiplerle karşılaştırıldığında modellerini çok daha ucuza sunabiliyorlar. Bu dikey entegrasyon, hem eğitim hem de sunum aşamasında Google’a önemli bir maliyet avantajı sağlıyor.

Google, her zaman, muazzam hesaplama kaynaklarına, derin araştırma yeteneklerine, kanıtlanmış yapay zeka atılımlarına ve entegre bir veri ve hesaplama gücü ekosistemine sahip bir dev oldu. Yeni Gemini-deneysel modelleri önceki modellerinden daha iyi görünüyor. Hatta, kısa bir süre için [lmarena]’da 1 numara oldular ve şimdiye kadar gemini-flash-1.5, çok ucuz bir alternatif sunarak büyük bir başarı elde etti. OpenRouter’daki kullanımları her geçen gün artıyor, bu da kullanıcıların gemini-flash’in fiyat/etkinlik oranından memnun olduğunu gösteriyor.

Ayrıca, Gemini 2.0’nin bazı dahili belgeler aracılığıyla sızdırıldığı ortaya çıktı. Deneysel model sızıntılarında Gemini-Flash-2.0’ı gördük ve kıyaslama sonuçları harika görünüyor. Aynı fiyat seviyesinde sunulursa, inanılmaz derecede fiyat rekabetçi bir küçük model olabilir.

Google’ın araştırma gücü, her zaman en önemli yeteneklerinden biri oldu; ancak büyüklükleri nedeniyle ürünleştirme süreçleri her zaman çok uzun sürdü. Logan Kirkpatrick’in gelişinden bu yana bu süreçler iyileşti. Google (Alphabet) küresel olarak 190.000 çalışana sahip. Google DeepMind yaklaşık olarak 2000 kişiyi istihdam ediyor. Karşılaştırma olarak, OpenAI yaklaşık 1200 kişi ve Anthropic ise yaklaşık 1000 kişi çalıştırıyor.

NotebookLM Google’ın en iyi ürünlerinden biri - araştırma güçlerini kullanıyor ve yapay zeka yeteneklerinin, özellikle belge anlama ve analizi konusunda, gerçek dünya uygulamalarını gösteriyor. Araştırma makalelerinden küçük, sindirilebilir podcastler oluşturmak ve bu podcastleri daha da iyi hale getirmek için özel sistem komutları kullanmak harika bir fikirdi. İlk günden beri bağlandım ve NotebookLM sayesinde bazen dinlediğim, özel sorgularla 20’den fazla araştırma makalem var.

Google’ın araştırma ve hesaplama gücünün bir başka harika uygulaması da yakın zamanda yayınlanan Genie 2.0. Bu model, çok modlu yapay zekada önemli bir ilerlemeyi temsil ediyor. Model hem görselleri hem metinleri anlayıp üretebiliyor, ama daha da önemlisi, görsel sahnelerdeki karmaşık etkileşimleri ve fiziksel dinamikleri kavrayabiliyor. Bu, nesnelerin nasıl hareket edeceğini ve etkileşime gireceğini tahmin etmesini sağlıyor ve bu özellikle oyun ve simülasyon uygulamaları için çok güçlü. Genie 2.0, genel ürünleştirme süreci yavaş kalsa da, Google’ın muazzam hesaplama kaynaklarını kullanarak belirli yapay zeka alanlarında sınırları zorlama yeteneğini gösteriyor.

Alphabet ailesinin ürünleri, özellikle YouTube ile başlayarak, LLM kullanımında büyük fayda sağlayabilir. Çok daha doğru transkriptler oluşturabilir ve 140’tan fazla dilde çeviri sağlayabilir. Maliyet, muhtemelen bu özelliklerin henüz tam olarak uygulanmamasının bir nedeni olabilir. Ancak, araştırma ve hesaplama güçlerinden faydalanabilecekleri birçok ürünleri var. Ne var ki, bu yenilikleri uygulamaya geçirmeleri o kadar uzun sürüyor ki, genellikle startuplar önce ürünleri oluşturuyor. Google ihtiyaç duyduğu noktaya gelene kadar, pazar genellikle bir sonraki aşamaya geçmiş oluyor. Bu yüzden Google’ı inanılmaz bir dev olarak görüyorum. Ama, ölçek nedeniyle yavaş hareket eden bir dev.

Google saf kaynak avantajı sayesinde büyük bir oyuncu olarak konumunu korurken, “İlahi Yetki” için asıl savaş giderek OpenAI ile daha genç, odaklı bir rakip arasında yoğunlaşacaktır. Peki neden Anthropic’i OpenAI’ın en önemli rakibi olarak görüyorum?

Anthropic (CTO)

23 Temmuz 2024’te Anthropic, Claude Sonnet-3.5’i yayınladı. Bu, benim görüşüme göre, “İlahi Yetki”’nin el değiştirdiği andı. Sonnet-3.5’ten önce, Anthropic’in en iyi modeli Opus-3’tü ve oldukça güçlü olmasına rağmen GPT ailesinin açıkça kazandığı alanlarda hala eksikleri vardı. Ancak Sonnet-3.5 ile birlikte, temel model düzeyinde En İyi Teknoloji (SOTA) hakimiyeti Anthropic’e geçti. Anthropic, modellerini Meta’nın Llama ailesinin 7B - 70B - 405B sayısal temsiline benzer şekilde, parametre sayısına göre Haiku - Sonnet - Opus olarak adlandırıyor. Sonnet-3.5, GPT’nin en büyük modellerini orta boyutlu modellerle yendi. Ama, asıl öne çıktığı alan mühendislik ve kodlamaydı. Birden GPT ailesinin hiç sağlayamadığı seviyede bir eş-programcıya sahip olmak mümkün oldu. Bu, ürünlerini ve karmaşık fonksiyonlarını yazmak için LLM’leri kullanan kişilerin hemen dikkatini çekti ve sonuçlar hakkında övgüyle bahsettiler. Yavaş, ama emin adımlarla, kod ile çalışan çoğu kişi Sonnet-3.5’e geçiş yaptı.

Yapay zeka silahlanma yarışında Anthropic’in yükselişine sadece güvenlik ve hizalama değil, aynı zamanda model kalitesi de yol açtı. OpenAI’daki huzursuzluğun tek bir kaynağı yok, ancak, kaynak tahsisi birincil sorun. Güvenlik ve hizalama ekibine söz verilen hesaplama gücü, kendi sözleriyle yeterince önceliklendirilmedi ve bu durum, LLM’lerin şu andaki ölçeği ve yetenekleri göz önüne alındığında OpenAI’da birden fazla kişiyi endişelendirdi.

Anthropic’in kendi reklamı, son aylarda OpenAI’dan Anthropic’e doğru kayan hakimiyeti benim anlatabileceğimden daha iyi gösteriyor.

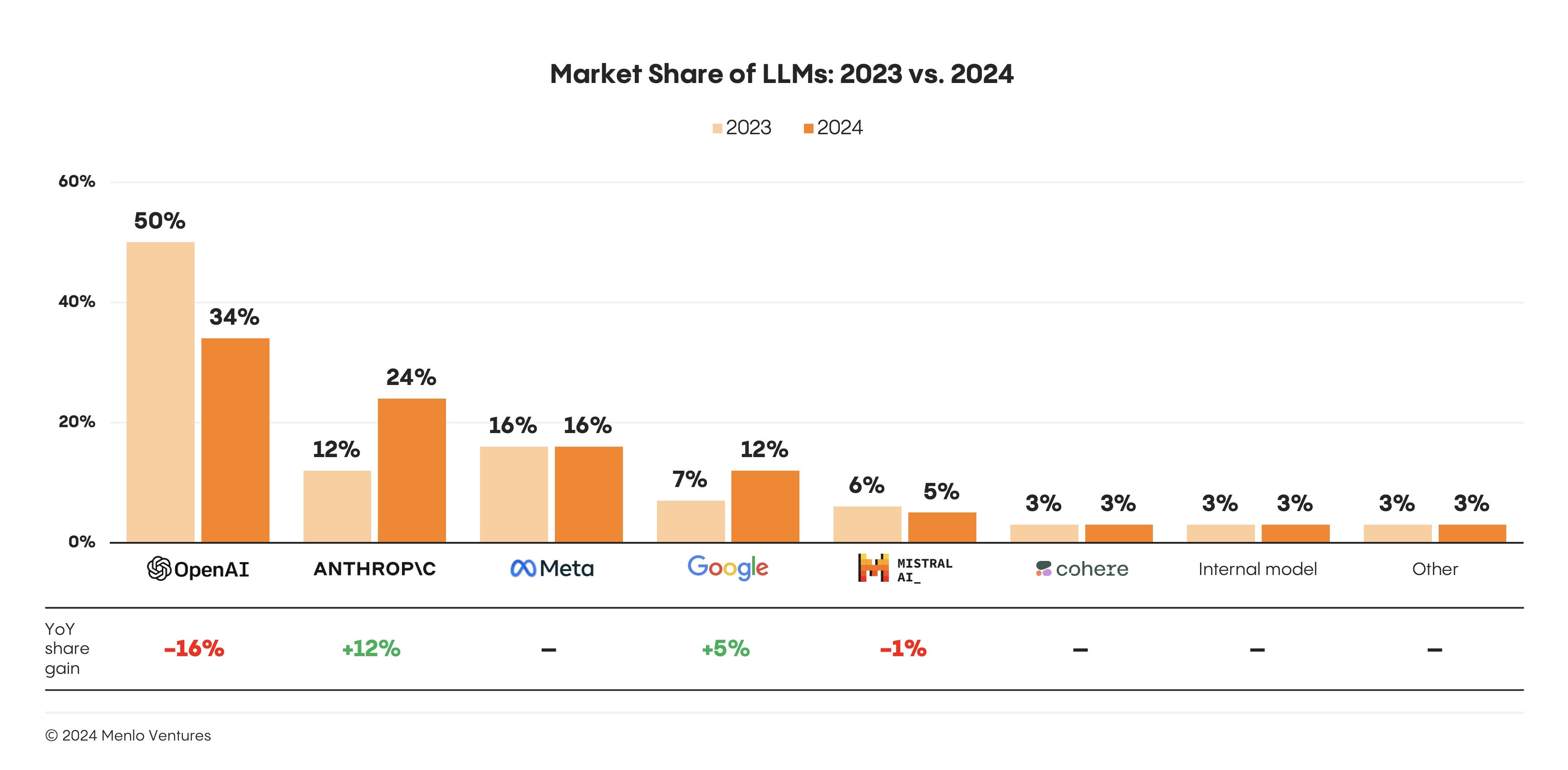

OpenAI beklendiği gibi 2024’te LLM oyunundaki ilk hamle avantajının çoğunu kaybetti ve %16’lık pazar payı kaybının çoğunun Anthropic’in kazanımına gittiği görülüyor. Anthropic’in payı 2023’te %12’den 2024’te %24’e yükseldi (ki bunun daha da artacağını tahmin ediyorum).

Kapalı kaynak modeller arasında, OpenAI’ın erken hamle avantajı bir miktar erozyona uğradı ve kurumsal pazar payı %50’den %34’e düştü. Bundan asıl faydalanan Anthropic oldu. Bazı işletmeler yeni model en iyi teknoloji haline geldiğinde GPT-4’ten Claude 3.5 Sonnet’e geçiş yaptı ve Anthropic’in kurumsal varlığı %12’den %24’e ikiye katlandı. Organizasyonlar yeni bir LLM’e geçerken en sık güvenlik ve emniyet değerlendirmelerini (%46), fiyatı (%44), performansı (%42) ve genişletilmiş yetenekleri (%41) motivasyon olarak gösteriyor. - Menlo Ventures, 2024: Kurumsal Alanda Üretken Yapay Zekanın Durumu

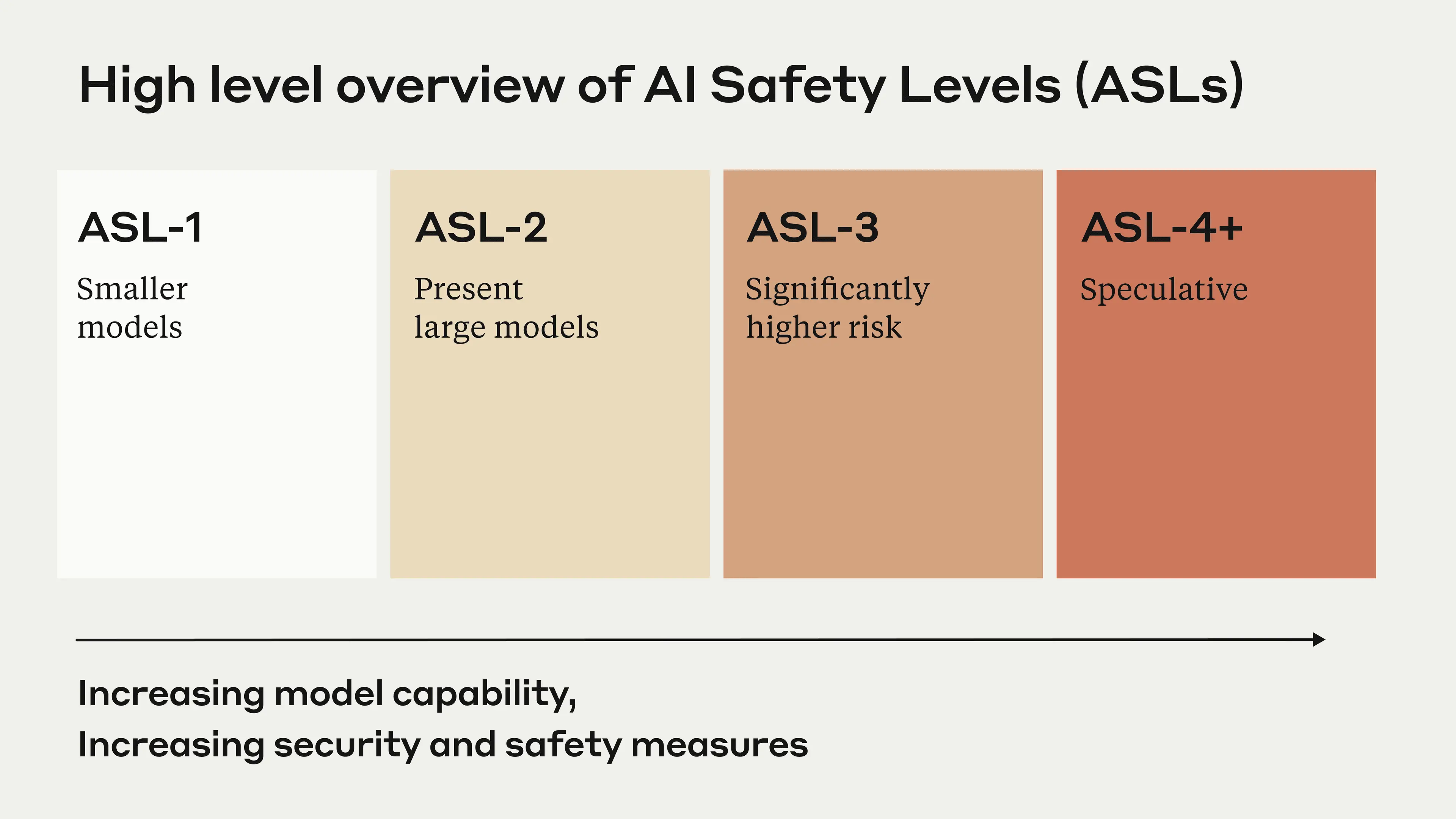

Eğer, Anthropic’in yakın zamandaki Lex Fridman’ın podcast görünümünü dinleme şansınız olduysa, Dario Amodei, Amanda Askell ve Chris Olah’ın toplam 5 saat 15 dakika boyunca sırayla konuştuğu bu yayın harika bir dinleme. Konuşma sırasında Dario, Yapay Zeka Güvenlik Seviyeleri ve Sorumlu Ölçeklendirme Planları hakkında konuşuyor. Bu, Yapay Zeka Güvenlik Seviyeleri veya kısaca ASL konseptini tanıtıyor. ASL 5 seviyeden oluşuyor.

- ASL-1 (Küçük modeller: Herhangi bir özerklik riski oluşturmazlar. örnek: DeepBlue)

- ASL-2: Mevcut büyük modeller ki otonom görevleri uçtan uca tamamlayacak kadar akıllı değiller. KBRN riskleri oluşturabilecek bilgilere sahipler; ancak bir kullanıcı modele talimat vermeden bu riskleri uygulayamaz veya zararlı eylemde bulunamazlar. (KBRN: Kimyasal, biyolojik, radyolojik ve nükleer savunma)

- ASL-3: Kullanıcıların zarar vermek ve yıkım yaratmak için çok daha az yetkinliğe ihtiyaç duyduğu, önemli ölçüde daha yüksek riskli modeller. Model, görevleri uçtan uca daha güvenilir şekilde yürütürken zararlı eylem gerçekleştirme konusunda daha yetenekli.

- ASL-4+: Modellerin zararlı bir aktörün riskini artırabileceği veya yanlış hizalanırsa kendilerinin bir risk haline gelebileceği spekülatif alan.

- ASL-5: İnsanlığı herhangi bir görevde aşan modeller.

Dario şöyle belirtiyor: “Bu riskleri ele almak şaşırtıcı derecede zor, çünkü bugün burada değiller, mevcut değiller, hayaletler gibiler. Ama modeller çok hızlı geliştiği için bize çok hızlı yaklaşıyorlar.” Her yeni modelle birlikte, yeni eğitilen modelin mevcut yeteneklerini anlamak için baştan sona her şey test ediliyor ve kıyaslanıyor. Ayrıca aradıkları şey “Bu modeller KBRN görevlerini ne kadar otonom olarak gerçekleştirebiliyor.”

Şu anda her araştırma laboratuvarı, en büyük ve en yetenekli modellerinin yapay zeka araştırmasının bazı yönlerini kendi başına yapmasını sağlamaya çalışıyor. Bu, modellerin, insanların hem kalite hem de zaman kısıtlamaları açısından (hesaplama süresi çok daha hızlı olabilir) geliştirebileceğinin ötesinde gelişeceği umuduna dayanan bir çark oluşturuyor. Model geliştirmeyi otomatikleştirmede bu noktaya ulaşabilirseniz, bu kaynaklarınızı ve araştırmacılarınızı modellerin nasıl daha iyi performans gösterebileceğini araştırmak yerine modellerin ne yaptığını izlemeye ayırmanın önünü açar. Çünkü, model kendini geliştirme görevini üstlenmiş olacak, dolayısıyla insanlar olarak bizim amacımız geliştirilen şeyin insanlık ve medeniyetimiz için güvenli olmasını sağlamak olacak.

Eğer, modeller mevcut ASL-2 güvenlik seviyesinden ASL-3’e geçerse, bu gerçekleşmeden önce uygun güvenlik kılavuzlarının yerinde olması gerekiyor. Araştırma laboratuvarlarının eğitim sonrası, hizalama ve güvenlik araştırmaları yapmasının nedeni bu. Anthropic’in Anayasal AI adında bir katmanı daha var ki, bu, modelin verilen sorguları yürütürken bağlı kaldığı bir sistem komutu olarak düşünülebilir. Başkalarına zarar verme, terörizm, biyo-kimyasal silah üretimi vb. içeren sorgulara yanıt vermeme veya reddetme gibi. Ayrıca belirtmeliyim ki, Claude kullanıcı sorgularını en çok reddeden model çünkü güvenlik önlemleri üst üste katmanlanmış durumda, böylece sorgudaki her kelime bir güvenlik ihlali olarak yanlış yorumlanabilir ve model, kullanıcının onu yanlış bir yöne yönlendirmeye çalıştığını öngördüğü için sorguyu yanıtlamayı reddeder. Anthropic’in red oranı diğer modellere göre oldukça yüksek ve bu durum, bir dadı veya anne gibi davranarak kullanıcılarını zaman zaman çocuklaştırdığına dair bir iç şaka/eleştiri konusu olmuş durumda.

OpenAI’dan güvenlik ve hizalama araştırmacılarının büyük çoğunluğu açık kaynak veya Anthropic’e geçti. İnanıyorum ki düzgün güvenlik ve hizalama araştırması olmadan, OpenAI’ın rakipleri arasında en iyi modele sahip olması önemli olmayacak. Eğer modeli kontrol edemez ve özerkliğinde güvenliğini sağlayamazlarsa başarısız olmuş olacaklar. Anthropic’in güvenlik yaklaşımı ve Dario Amodei’nin (Anthropic’in CEO’su, OpenAI’ın eski Araştırma Başkan Yardımcısı) bu alandaki kendi araştırmaları (mekanistik yorumlanabilirlik, hizalama, güvenlik vb.) beni Anthropic’in kendini ASL-3 ve ASL-4 modellerinin zorlukları için benzersiz bir şekilde konumlandırdığına inandırıyor. Rakipler eşit derecede yetenekli modeller geliştirebilse de, bu modelleri güvenli bir şekilde devreye alma ve kontrol etme yeteneği muhtemelen pazar payını korumada kilit farklılaştırıcı olacak. Google’ın OpenAI ile birlikte ASL-3 ve ASL-4 modellerini sunmada ilk başarılı olacağına inanıyorum. Ama, bu, sonunda açık kaynağa da sızacak.

Bu durum Anthropic’in kazandığı ve “İlahi Yetki”’yi devralmak için her şeyi doğru yaptığı güzel bir tablo çiziyor. Ancak, hiçbir kral sonsuza dek hüküm süremez. Ürün taraflarında OpenAI’a kıyasla büyük eksiklikleri ve olgunluk sorunları var. Örneğin, bu kadar güçlü modeller üretebilen bir araştırma laboratuvarı için artık olmazsa olmaz gördüğüm web arama yetenekleri hala yok. Ayrıca o1 gibi kendi test-zamanı-hesaplama paradigmaları veya buna bir cevapları yok. Düşünce Zinciri muhakemesi uyguluyorlar, ancak bu o1 modelinde görülen paradigma değiştirici seviyede değil. İnsanlar, yanıtlarında antthinking (anthropic thinking’in kısaltması) belirteci çıktıları rapor ediyor ki, bu Claude’un, kimsenin detaylarını bilmediği, bir tür düşünce zinciri yaptığına işaret ediyor.

Sonnet-3.5’in (24.11.24_güncellemesi) bazı görevlerde o1-pro’yu yenmesi ve ondan daha iyi olması akıl almaz. Çünkü, bu sadece tüm süslü özellikler olmadan yanıt veren ön-eğitimli bir model. Sonnet-3.5, o1 gibi pahalı muhakeme belirteçleri üreten ve en iyi yanıtı bulmak için yanıtları üzerinde arama yapan bir model değil, size en iyi yanıtı ilk denemede veriyor - bam! Claude’da insanları şaşırtan da bu. Bu paradigmayı bile eklemeden bu kadar iyi. Claude Opus-3.5 ve diğer modelleri alt üst edebilecek büyük bir model için güçlü bir talep olsa da, Dario podcast’te Opus-3.5’ten bahsetmesine rağmen bu gerçekleşmeyebilir. Bunun nedeni, büyük modellerin orta boy modellere aktarımda çok iyi hale gelmesi ve çok büyük bir model eğitmenin artık maliyet açısından verimli olmaması. Girilmesi gereken bir yarış, ama, her çalıştırmanın maliyeti ve kazanımların belirsizliği nedeniyle hiçbir yapay zeka laboratuvarı bunu istemiyor.

Şimdilik, optimal çözüm hibrit bir yaklaşım gibi görünüyor: sonnet-3.5’in (24.11.24 güncellenmiş versiyonu) o1’in muhakeme yetenekleriyle geliştirilmesi. Bu kombinasyon güvenlik, yetenek ve pratik fayda arasındaki mevcut doğru noktayı temsil ediyor.

xAI (Kara At)

Elon Musk, OpenAI’ın en erken yatırımcılarından biriydi. Ancak, Elon CEO pozisyonunu istediğinde görüşmeler durma noktasına geldi. Bu durum, finansman görüşmeleri sırasında Sam Altman’ın CEO pozisyonuyla (ki Altman bu pozisyonu istemediğini ama “herkesin kimin yönetimde olduğunu bilmesi için gerekli olduğunu” hissettiğini belirtti) çatıştı ve sonunda Musk ile OpenAI arasındaki tüm iletişimi durdurdu. Bu görüşmeler 2016’da gerçekleşti. Dolayısıyla, OpenAI’ın şu andaki başarısı düşünüldüğünde Musk’ın hissedebileceği üzüntü ve pişmanlığı hayal edebilirsiniz. Gelecek bilişim devriminin en büyük destekçilerinden biri olabilirdi ve bir bakıma aslında öyleydi. Ancak, OpenAI bugünkü dev haline gelmeden önce dışlandı.

Şimdi xAI’ya, her büyük araştırma laboratuvarıyla rekabet eden kendi yapay zeka şirketine sahibiz. Yaklaşık 10 milyar dolar değerinde en büyük yapay zeka süper kümesini çoktan inşa ettiler. Paralel bir hamleyle, Elon aynı zamanda yasal yollarla OpenAI’ın kâr amacı gütmeye başlamasını engellemeye çalışıyor - ki, bu, Elon’un Sam Altman’ın boğazına sıktığı ve kendisinin kazdığı kâr amacı gütmeyen mezardan çıkmasının tek yolu gibi görünüyor.

Para toplamak ve daha büyük, daha iyi modeller eğitmek, bu araştırma laboratuvarlarının karşılaştığı en büyük sorun. Yatırımcılarını, mevcut yatırımların önemsiz kalacağı kadar büyük kazanımlar elde edebileceği bir süper zekaya ulaşacakları veya muazzam üretkenlik artışları sağlayacakları konusunda ikna etmek zorundalar. Her büyük eğitim çalışması bir fon toplama gösterisine dönüşüyor. Elon’un bu kurallara göre oynaması gerekmiyor. X’in sahipliği ve Tesla’dan gelen büyük kaynakları sayesinde, geliştirmeyi bağımsız olarak finanse edebilir ve kendi hızında ilerleyebilir.

X’i satın alarak Elon, başkanlık yarışını Donald Trump’ın lehine değiştirdi ve onu başkanlık koltuğuna oturtmayı başardı. Bunun hepsi Elon’un eseri miydi? Hayır. Önemli bir rol oynadı mı? Donald Trump’ı seçtirmek için elinden gelen her şeyi yaptığından ve Ocak ayında Trump, Beyaz Saray’da yemin ettiğinde, bu faydaları 5-10 kat geri alacağından emin olabilirsiniz. Biden yönetimi, sadece seçilmiş birkaç araştırma laboratuvarının sınırları zorlayan SOTA modelleri eğitmek için gereken hesaplama gücüne veya kaynaklara sahip olmasını tercih etti. Ancak, Trump’ın, daha fazla şirketin bu görüşmelere davet edilmesi ve bu görüşmeleri yönlendirmesi ve şekillendirmesi için kime güvendiğini tahmin edebilirsiniz. Evet, bu, onu göreve getiren kişi olan Elon Musk ve yeni atanan czar David Sacks’ten başkası değil.

Elon’un odağı şüphesiz xAI ve Tesla’nın başarısında, ki bu ikisi görünenden çok daha bağlantılı. Grok, X üzerinde çalışıyor, xAI çalışanları tarafından eğitiliyor ve büyük ölçüde Elon’un Tesla ve diğer girişimlerinden elde ettiği kârlarla finanse ediliyor. Onun geçmiş başarıları, rakiplerinin yaptığı gibi vaatler veya gösteriler gerektirmiyor. O, her zaman hızlandıran kişiydi ve öyle kalacak. Çünkü, bu onun çalışma şekli. Hızlı, yalın ve bazen yıkıcı ama sürekli sonuç veriyor.

Grok-2, şu anda sınır seviyesinde olsa da, OpenAI, Google ve Anthropic’in yanında yapay zeka silahlanma yarışı ekosisteminde kesin yerini henüz bulamadı. API erişimleri beta aşamasında kalıyor ki bu geliştirici adaptasyonunu sınırlıyor. Oysa,bu herhangi bir yapay zeka platformunun başarısı için kritik bir faktör. Ancak, xAI’ın kaynakları ve Musk’ın uygulama hızı göz önüne alındığında, bu gecikme muhtemelen uzun sürmeyecek.

Bir yıl ileriye baktığımızda, ipi önde göğüsleyen modelin veya “İlahi Yetki”yi elinde tutanın kim olacağını tahmin etmek imkansız olsa da, xAI’ın mevcut oyunculardan en az %10 pazar payı alacağına, hatta kendilerinin SOTA statüsüne ulaşacağına bahse girerim. Bu, sadece teknik yetenek meselesi değil, daha geniş anlamda, endüstri dinamikleri değişiyor. Yapay zeka geliştirmede, geleneksel kapalı-kapı yaklaşımı, zaten Llama, Mistral, DeepSeek ve özellikle Alibaba’nın Qwen’i gibi etkileyici açık kaynak modellerle zorlanıyor. Qwen’in yakın zamandaki Qwen-2.5(72B) modeli, Llama’yı lider açık kaynak model olarak yerinden etti. Musk’ın kaynakları, kararlılığı ve yerleşik endüstrileri altüst etme geçmişiyle, xAI’ı yapay zeka yarışının dışında tutmak ciddi bir hata olur.

Test-Zamanı-Hesaplama (TZH), Ön-eğitim ve Yeni Paradigmalar

Test-zamanı-hesaplama nedir, insanlar neden ön-eğitim konusunda bir zeka duvarına çarptığımızı söylüyor ve ufukta bizi ne bekliyor?

Test-zamanı-hesaplama, en basit açıklamayla, LLM’e sorduğunuz soru ne kadar zorsa, modelin doğru bir yanıt vermek için o kadar uzun düşünebilmesi anlamına geliyor. Şu anda modeller yanıtlarını tek seferde veriyorlar ve söyledikleri üzerinde adım adım düşünmüyorlar. 6 ay önce modeli bir tür Düşünce Zinciri (Chain of Thought) uygulamaya zorlamak için komutunuza “Lütfen bu problemi adım adım çöz ve yanıtlarını kontrol et” eklerdiniz. Noam Brown’ın satranç ve diğer alanlarda Monte Carlo Ağaç Aramasını kullanma konusundaki önceki çalışmaları, test-zamanı-hesaplamanın altında yatan şeyle ve yeni o1-preview modellerinin sorularınızı nasıl yanıtladığıyla derin bir ilişkiye sahip.

Monte Carlo Araması’nın kısa bir açıklamasını yapmak gerekirse 4 unsurdan oluşur:

Monte Carlo Ağaç Araması (MCAA), özellikle oyunlarda ve simülasyonlarda, karar verme görevlerinde yaygın olarak kullanılan bir yöntemdir. Süreç şunları içerir:

- Seçim: Umut verici yolları seçmek için keşfetme-sömürme dengesi temelinde bir karar ağacını tarama.

- Genişletme: Seçilen durumdan olası eylemlerin sonuçlarını simüle etme.

- Simülasyon: Gelecekteki sonuçları tahmin etmek için rastgele veya sezgisel-güdümlü simülasyonlar çalıştırma.

- Geri Yayılım: Gelecekteki karar kalitesini iyileştirmek için simülasyonların sonuçlarıyla karar ağacını güncelleme.

Bu süreç, o1’in nasıl çalıştığına dair inancımla özellikle ilgili. Bir satranç motoru nasıl MCAA kullanarak farklı hamle dizilerini değerlendiriyorsa, o1 de benzer şekilde çalışıyor gibi görünüyor:

- Önce umut verici yaklaşımları seçiyor (Seçim)

- Bunları detaylı muhakeme zincirlerine genişletiyor (Genişletme)

- Bu zincirlerin doğruluğunu test ediyor (Simülasyon)

- Öğrendiklerini yanıtını iyileştirmek için kullanıyor (Geri Yayılım)

Bu eylemler, “mantıksal düşünme” dediğimiz şeye çok yakın. Bir fikir/kavram seçiyoruz, zihnimizde bunu detaylandırıyoruz, fikrimizin doğru veya uygulanabilir olup olmadığını hızlıca test ediyoruz ve düşüncemizi simüle edilen fikirle uyumlu hale getiriyoruz. Bu yinelemeli iyileştirme süreci, o1’in yaptığını düşündüğüm şeyi yansıtıyor - sadece daha uzun düşünmek değil, muhakemesini çoklu geçişlerle rafine etmek.

OpenAI’daki insanlar dışında kimse o1-preview’in tam olarak nasıl çalıştığını bilmiyor. COT çıktılarının gösterilmesi, başkalarının o1’in nasıl çalıştığını tersine mühendislikle çözmesine olanak sağlayabileceği için bu kasıtlı bir perdeleme.

Alibaba’nın Qwen-QwQ’su yakın zamanda o1-preview’in yeteneklerini eşleştirmeye çalışan tek açık kaynak kodlu rakip oldu. İngilizce yanıt vermesini açıkça belirtmediğiniz sürece bazen Çince’ye geçmek gibi tuhaf davranışları olsa da, düşünce zincirini yanıtlarına dahil ediyor. o1-preview teknik bir harika olsa da, token limitleri ve yüksek API maliyetleri nedeniyle deneysel aşamada kalıyor. 5 Aralık 2024 itibariyle, yoğun kullanıcılar için 200$ karşılığında bu kısıtlamaları kaldırdılar ve o1’in tam versiyonunu yayınladılar, ancak bazen o1-preview’den daha kötü performans gösteriyor. API erişimi henüz yayınlanmadı.

Bu bizi yapay zeka geliştirmede paradigma değişimine getiriyor. O1-preview’den önce, daha akıllı modeller elde etmek tek bir şey anlamına geliyordu: daha fazla veri ve hesaplama gücüyle ön-eğitim. O1-modeli, TZH’yi tamamen yeni bir ölçeklendirme boyutu olarak tanıttı. Kavram basit: bir model bir problem hakkında ne kadar uzun düşünebilirse, yanıtı o kadar doğru (güvenilir) hale geliyor. Şu anda o1 saniyeler veya dakikalar boyunca düşünüyor, ancak OpenAI modellerin karmaşık STEM araştırma problemlerini günler, haftalar, hatta aylar boyunca düşünebileceği senaryoları öngörüyor.

OpenAI’ın o1’in yayınlanmasında paylaştığı yukarıdaki grafik, onların gurur kaynağı. Dikkat çekici nokta, normal zaman ölçeği yerine logaritmik zaman ölçeği kullanılması. Grafik, o1’in AIME (Amerikan Davetli Matematik Sınavı) sorularında, daha uzun düşündükçe, ilk denemesinde bile giderek daha doğru yanıtlar verdiğini gösteriyor. Bu, yeterli düşünme süresi verildiğinde herhangi bir görevde neredeyse mükemmel doğruluk elde edilebileceği olasılığını düşündürüyor.

Bu eğilimin matematiksel problemlerin ötesinde geçerli olacağından emin olamasak da, OpenAI bunu AGI’ye giden potansiyel yolları olarak görüyor. Bu paradigmanın, MCAA’nın olası satranç hamlelerinin bulanık dünyasını yinelemeli iyileştirmelerle yapılandırılmış, optimal kararlara dönüştürmesi gibi, bulanık bir çıktı dünyasını, sorgu ve bilgi tabanı üzerinde yapılan aramalarla yapılandırılmış çıktılara dönüştüreceğine güveniyorlar.

Meta’nın Açık Kaynak Stratejisi

Meta’nın yapay zeka yarışındaki yaklaşımı hakkında çok yorum yapmak istemiyorum. Çünkü, diğer araştırma laboratuvarlarından temelde farklı olarak en gelişmiş modeli yaratmak için değil, açık kaynak erişilebilirliği üzerinden yaygın adaptasyon stratejisi izliyorlar. Bu strateji, Meta’nın donanım altyapısındaki başarılı yaklaşımını yansıtıyor. Zuckerberg’in belirttiği gibi: “Donanım altyapı tasarımlarımızı Open Compute Project üzerinden açık kaynak yaptığımızda, herkes birbirinin çalışması üzerine inşa edebildiği için endüstri genelinde büyük maliyet düşüşleri sağladı. Yapay zeka ekosistemi daha açık hale geldikçe benzer faydaların ortaya çıkmasını bekliyoruz.”

Donanım tasarımlarının açık kaynak yapılması nasıl maliyetleri düşüren işbirlikçi bir ekosistem yarattıysa, Meta’nın Llama stratejisi de yapay zeka geliştirmeyi daha erişilebilir ve maliyet-etkin hale getirmeyi amaçlıyor. Model ve araştırmalarını kamuya açık yayınlayarak, geliştiricilerin teknolojilerini kolayca üzerine inşa edebileceği ve özelleştirebileceği bir ortam yaratıyorlar. Bu yaklaşım teknik üstünlük için rekabet etmek yerine yaygın adaptasyon yoluyla pazar payını büyütmeye odaklanıyor.

Çin Yapay Zeka Sahnesi

İlk olarak, Aksel Johannesen’in Çin yapay zeka sahnesi hakkında yazdığı çok iyi bir makaleye dikkat çekmek istiyorum. Çin Yapay Zeka Pazarında neler olup bittiğini daha iyi anlamak istiyorsanız, devam etmeden önce bu makaleyi okumanızı tavsiye ederim.

Şu anda Çin’den üç ciddi rakip görüyorum: Alibaba’nın Qwen’i, DeepSeek’in model ailesi ve 01.ai’ın Yi’si. Yi hakkında en az bilgiye sahibim. Ancak, hem Qwen hem de DeepSeek’i kullandığım için yeteneklerinden daha iyi bahsedebilirim.

Qwen şu anda 72B eğitim modeli ve kodlayıcı varyantıyla pazara hakim durumda. Tamamen açık kaynak olmaları sayesinde hem DeepSeek hem de Qwen önemli topluluk geliştirmesi çekti. Ayrıca, pek çok kişi de onları, yerinde çözüm oldukları için seçiyor. Unutmayın ki sadece altı ay önce bu pozisyon tamamen Meta’nın Llama’sı tarafından domine ediliyordu. Ancak Meta’nın son modelleri önceki versiyonlardan daha küçük gelince, Qwen açık kaynak SOTA pozisyonunu ele geçirme fırsatını yakaladı.

Bunun nedeni, oldukça basit: hem Qwen hem de DeepSeek yeni modeller ve teknolojiler için hızlı üretim-zamanına sahip. Daha önce bahsedildiği gibi, Qwen-QwQ şu anda COT ve TTC yeteneklerini uygulayan tek açık kaynak model. O1-preview’in başardıklarından çok uzak olsa da, o1’e yakın bir şey kopyalamaya çalışarak açık kaynağın sınırlarını zorladıklarını açıkça görebiliyorsunuz.

Meta, görsel tanıma ve daha küçük LLM modellerine odaklanarak sınır modellerinde geride kaldı. Qwen’i, açık kaynak kodlu modelde, SOTA pozisyonuna koyardım. DeepSeek-Coder ve Qwen-Coder, yerinde açık kaynak kodlama LLM’leri sağlamada neredeyse benzer kalitede. Ancak, ikisi de Sonnet-3.5-güncel’in yeteneklerine ulaşamıyor.

Sonuç: Sürekli Değişen Yetki

Hiçbir hanedan İlahi Yetkiyi süresiz elinde tutamadığı gibi, yapay zeka liderliğinin manzarası da aynı derecede akışkan. Kendimizi her birinin benzersiz güçler gösterdiği çoklu yarışmacıların bulunduğu büyüleyici bir dönüm noktasında buluyoruz. Anthropic kodlama ve çok turlu konuşmalarda SOTA statüsüne ulaşırken, Claude’un sesinde ayırt edici şekilde empatik bir yaklaşım geliştirdi. Bu arada OpenAI’ın “12 Days of OpenAI” kampanyası her gün yeni sürprizler açıklıyor ve diğerlerine “OpenAI savaştan çıkmadı ve hala çok baskın” sinyalini veriyor. Perde arkasında, xAI ve Google rekabet ortamını dramatik şekilde değiştirebilecek kaynaklara ve teknik yeteneğe sahipken, Amazon’un sürpriz girişi oyunun henüz bitmekten çok uzak olduğunu hatırlatıyor.

Yapay zekanın teknik evrimi ilerleme için birden çok yol sunuyor. Anthropic saf ön-eğitim uzmanlığıyla dikkat çekici yetenekler gösterirken, OpenAI’ın test-zamanı-hesaplama paradigması zekaya ulaşmak için tamamen farklı bir yaklaşım öneriyor. Claude’un Bilgisayar Kullanımı ve Model Bağlam Protokolü (MCP) yetenekleri, birçoklarının henüz tam olarak takdir edemediği şekillerde sınırları zorluyor. Bu özellikler, güçlü ön-eğitim temelleriyle birleştiğinde, keşfedilmemiş potansiyele işaret ediyor. Anthropic de er ya geç modellerinde bir tür test-zamanı-hesaplama kullanacak çünkü TZH bulmacanın çok önemli bir parçası. Bu, yakında her iki şirketin de en iyisini göreceğimiz anlamına geliyor.

Bu gelişmeler ortaya çıkarken, kendimizi daha derin sorularla boğuşurken buluyoruz. Yapay zeka geliştirmenin mevcut durumu kaynayan bir kazana benziyor. “Zekayı” anlama, damıtma ve uygulama arayışı her zamankinden daha büyük bir şekilde üzerimizde yükseliyor ve insan türünün modası geçmesi ve teknolojiyle değişen ilişkimiz hakkında kritik tartışmalara yol açıyor. İnsan toplumunu temelden değiştirecek bir dönüşümün ilk aşamalarına mı tanık oluyoruz? Bu yapay zeka sistemlerini şekillendirirken, onlar da aynı zamanda bizi şekillendiriyor - çalışma kalıplarımızı, düşünme süreçlerimizi ve zekanın kendisini anlayışımızı.

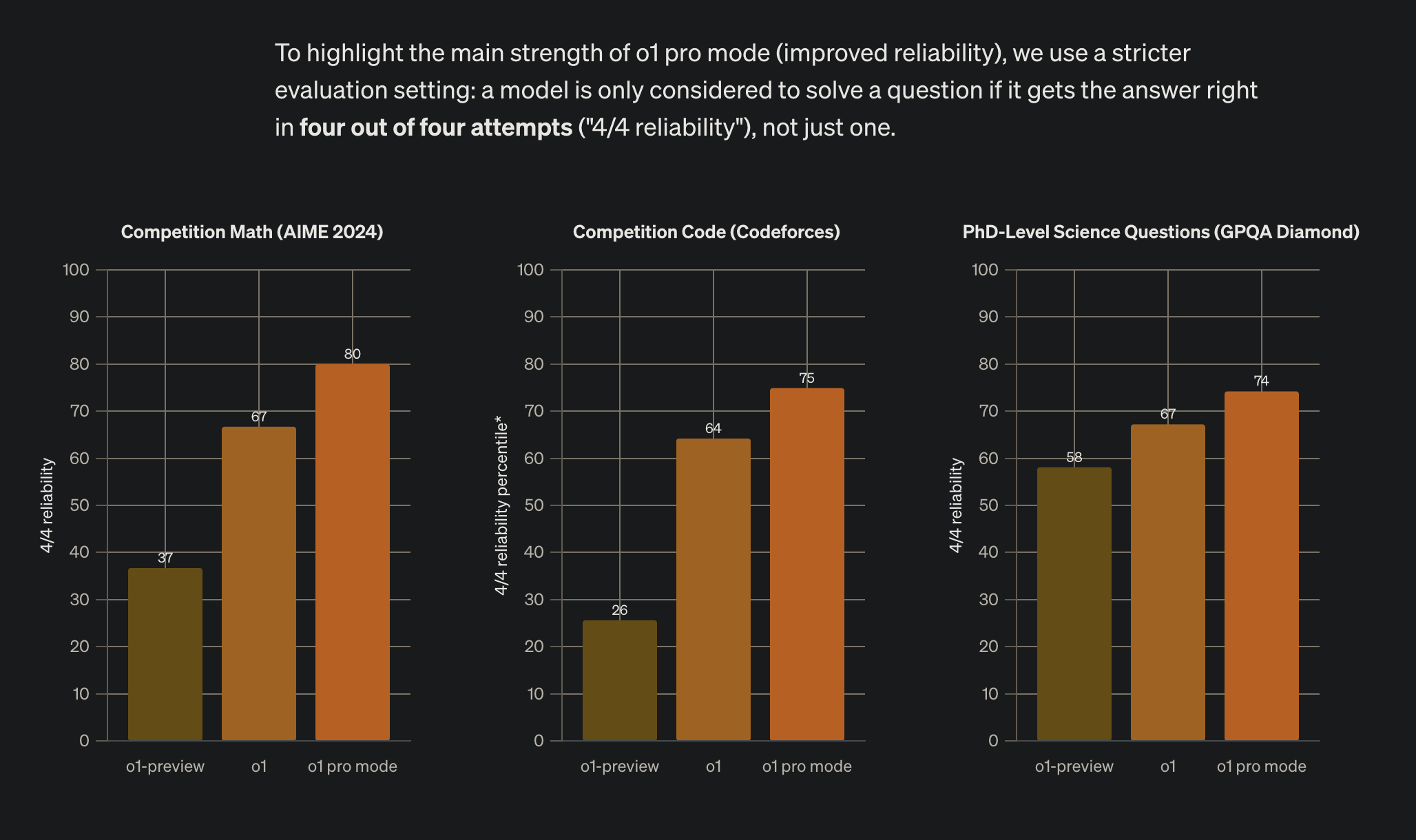

O1-pro şu anda belki en yetenekli genel amaçlı model olarak dursa da, Anthropic’in Sonnet-3.5’i belirli alanlarda üstün performans gösteriyor. Opus-3’ten beri yeni bir Opus sürümü görmemiş olmamız, Anthropic’in tam yetenekleri hakkında merak uyandırıyor. Her yaklaşım - ister OpenAI’ın mantık odaklı gelişimi, ister Anthropic’in önce güvenlik metodolojisi, isterse Meta, Mistral ve Çin şirketlerinin liderlik ettiği açık kaynak hareketi olsun - uygulanabilir ilerleme yolları sunuyor. İnsanların sorduğu temel metrik giderek ham yetenekten çok “güvenilirlik” oluyor. Bu yüzden o1’in büyük pazarlama iddiası daha güvenilir olması ve daha katı bir değerlendirme ayarı kullanması: “bir model ancak dört denemeden dördünde doğru cevabı verirse (‘4/4 güvenilirlik’) soruyu çözmüş sayılıyor, sadece bir kez değil.”

İleriye baktığımızda, yapay zekada “İlahi Yetki”yi her zamankinden daha öngörülemez kılıyor. Bugünün teknik avantajları yarının eski sistemleri olabilir. TZH’nin mevcut modellerle entegrasyonu, tamamen yeni paradigmaların ortaya çıkma potansiyeli ve açık kaynak alternatiflerin sürekli evrimi, hiçbir yaklaşımın veya organizasyonun kalıcı üstünlük iddia edemeyeceğini garanti ediyor. Hiçbir gün sıkıcı değil. Açık olan şu ki, sadece teknik üstünlük için bir yarışa değil, zekanın ne olduğunun temel bir yeniden hayal edilmesine tanık oluyoruz.

Bu dönüşümü yönetirken, farklı yaklaşımlar arasındaki sınırlar bulanıklaşabilir. Ön-eğitimli modellerin güvenilirliğini TZH’nin mantık yürütme yetenekleriyle birleştiren hibrit sistemler görebiliriz, ya da dönüşümcülerin yaptığı gibi mevcut tartışmaları geçersiz kılan yeni mimariler ortaya çıkabilir. Amazon’un girişi ve Çin modellerinin yükselişi, inovasyonun beklenmedik yönlerden gelebileceğini ve günümüz liderlerinin pozisyonlarını korumak için sürekli evrilmeleri gerektiğini hatırlatıyor. Sadece teknolojik olarak değil, bu araştırma laboratuvarlarında çalışan insanların da en iyilerden olması ve durumlarından memnun olmaları gerekiyor, yoksa bir gün en büyük rakibinize geçebilir veya daha kötüsü en büyük rakibiniz haline gelebilirler.

Bu sürekli değişen ortamda, belki de gerçek “İlahi Yetki” sonunda hızlı ilerlemeyi sorumlu geliştirmeyle, teknik inovasyonu pratik faydayla ve ham gücü güvenilir performansla dengeleyebilenlerde kalacak. Yapay zeka geliştirmenin bu kritik kavşağında, bir şey kesin: bu hikayenin bir sonraki bölümü herhangi bir yaklaşımı mükemmelleştirenler tarafından değil, inovasyonun çeşitli akışlarını parçaların toplamından daha büyük bir şeye sentezleyebilenler tarafından yazılacak. Bu alandaki başarı, sadece ürün, teknoloji veya araştırma parlaklığı değil - tüm bu elementlerin, sarsılmaz kararlılık ve kapsamlı anlayışla güçlendirilmiş bir uyumunu gerektiriyor.

Kişisel bir notla kapatmak istiyorum: Eğer analizlerim/yorumlarım, bu araştırma laboratuvarlarında çalışan herhangi birinin çalışmalarını önemsemediğim izlenimini verdiyse, bu çıkarım gerçekten çok uzak olur. Hem kapalı araştırma laboratuvarlarında hem de açık kaynak topluluklarında çalışan herkesin katkıları, sohbete katılmaları ve yaratma şansını almaları, bu tarihi girişimin bir parçası olmaları için gösterdikleri çaba benim mutlak saygımı hak ediyor. Zaman sonunda her şeyi silip süpürebilir, ancak zekayı anlama ve yaratma konusundaki kolektif çabamız insanlığın en asil amaçlarından birini temsil ediyor. Kurumsal dinamiklerin ve pazar rekabetinin ötesinde şu temel gerçek yatıyor: yapay zeka geliştirme yoluyla insan bilgisini ve yeteneklerini genişletme arayışı, herhangi bir birey veya kuruluşun arkasında bırakabileceği değerli bir mirastır.